Очень , завтра уже будет поздно!

Другие вопросы по теме Информатика

Популярные вопросы

- Из справочной литературы узнай, как используют азот и углекислый...

3 - Почему лучше всего согревает меховая одежда?...

2 - Почему резиновый мяч подскакивает при ударе о землю?...

1 - Почему ветряные двигатели не загрязняют воздух?...

3 - Как можно доказать, что воздух, который находится во многих телах...

2 - Почему тучи или облака движутся по небу?...

3 - Как доказать, что тёплый воздух занимает больше места, чем холодный?...

2 - С каких игрушек можно доказать, что воздух занимает место?...

3 - Какое свойство воздуха позволяет нам видеть окружающий мир?...

3 - Как получают электричество, используя силу воды?...

2

Объяснение:

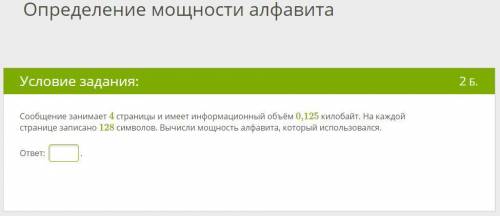

1.

Определяем количество символов в сообщении, для этого количество символов умножаем на количество страниц:

128 х 4 = 512 символов.

Находим сколько информации отводится на кодирование 1 символа:

0,125 Кбайт х 1024 = 128 байт или 128 х 8= 1024 бита всего в сообщении

1024 бита : 512 символов = 2 бита на 1 символ

Находим количество символов в алфавите по формуле N = 2^i:

N=2²=4

Мощность алфавита составляет 4 символа.

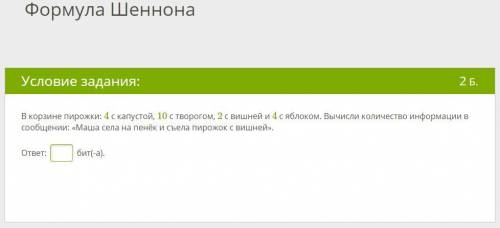

2.

Количество пирожков с вишней К1=2

Всего пирожков в корзине N=4+10+2+4=20

Вероятность выбора пирожка с вишней составляет

р1=К1/N=2/20=0,1

Теперь вычислим количество информации, содержащееся в сообщении, что Маша выбрала пирожок с вишней:

I1=log₂ (1/р1)=log₂(1/0,1)=log₂ 10=3,322 бита ≈4 бита (поскольку бит- минимальная единица информации и число бит не может быть дробным)

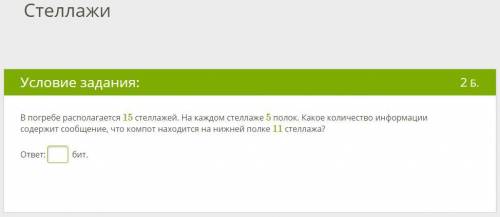

3.

2^i=N, где N - объём информации, а i - кол-во бит, которым кодируется единица информации. N=15*5=75

2^i=75

i=log₂ 75=6,23 бита ≈ 7 бит